최대한 빠른 시간에 많은 논문을 읽어야할 일이 생겨서, 딥하게 리뷰하지 않고, 수박 겉 핥기 수준으로 리뷰하는게 좋을 것 같아, 이제부터는 간단하게 리뷰하고 넘어가려고 합니다.

LLM과 3D 조합 시리즈를 이어갑니다. 아마 가장 최근 논문인 것 같네요. 2024년 12월에 아카이브에 올라온 논문입니다.

1. Introduce

기존 연구는 3D 데이터를 학습하기 위해 별도의 3D 장면 finetuning이 필요했고, 3D Point Cloud나 Voxel 등의 추가적인 복원 과정이 필요했습니다. 이를 통해 데이터 및 계산이 복잡했습니다. 따라서 본 논문은 RGB-D Video만을 이용해 3D 장면을 이해하고 LLM과 통합하여 MLLM으로 캡셔닝이 가능한 방법을 소개합니다.

2. Method

3.1. Frame Sampling Strategy

Input으로 들어온 RGB-D 비디오에서 3D 장면을 표현하기 위해 필요한 최소한의 비디오 프레임을 선택합니다.

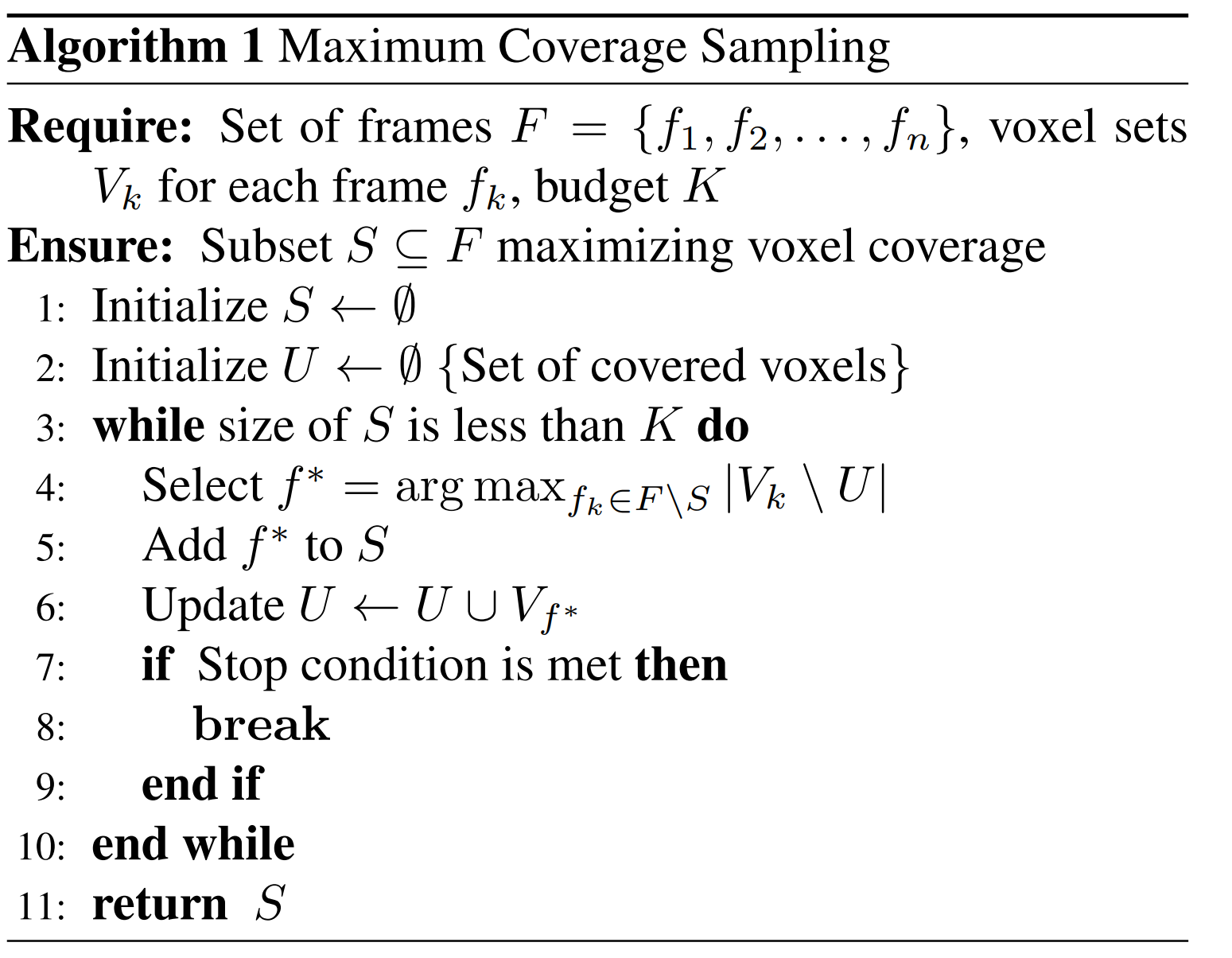

프레임 선택은 Maximum Coverage Problem 방법을 사용합니다.

이 알고리즘은 주어진 비디오 프레임 집합에서 최대한 많은 복셀을 커버하는 프레임의 부분집합을 선택합니다. 가능한 모든 K 프레임 조합을 탐색하지 않고, Greedy 알고리즘을 통해 매 단계에서 가장 많은 복셀을 커버한느 프레임만 선택함으로써 더욱 효율적으로 프레임을 선택하게 됩니다.

3.2. Position-Aware Video Representation

깊이 이미지(D)와 카메라의 내(K).외적(T) 행렬을 통해 픽셀 좌표--> 글로벌 좌표로 변환합니다.

Vision Transformer (ViT)를 사용해 프레임 이미지를 패치로 분할하여 각 패치의 특징을 추출해 비디오 프레임을 비주얼 임베딩으로 변환합니다.

그 이후, 각 이미지 패치에 대응하는 3D 글로벌 좌표(패치 내에 100개 픽셀이라면 100개의 3D 좌표를 평균) Sinusoidal Position Encoding을 통해 3D 좌표로 표현합니다. 각 패치에 대해 비주얼 임베딩과 3D 좌표 임베딩을 결합합니다.

3.3. Training Objective

본 논문의 훈련 목표는 단일 모델로 다양한 3D 장면에서의 작업 (Q&A, 캡션, 앵커링)을 처리할 수 있도록 학습하는 것입니다.

3.3.1. Q&A, Dense Captioning

Cross-Entropy Loss를 통해 모델이 입력된 3D 장면에 대해 자연어로 질의응답을 수행하거나, 3D 장면의 특정 영역에 대해 캡션(설명)할 수 있도록 학습합니다.

3.3.2. 3D Visual Grounding

모델이 주어진 3D 장면에서 특정 객체를 정확히 식별하고, 해당 객체의 위치를 3D 공간에서 앵커링(지정)할 수 있도록 학습합니다.

주어진 장면에서 bounding box를 생성하고, 비주얼 임베딩+3D 좌표 임베딩을 통해 객체 표현을 생성한 뒤, InfoNCE Loss를 통해 모델이 정답 객체와 유사도를 최대화하도록 학습합니다.

3. Conclusion

본 모델은 3D 장면을 이해하는 벤치마크에서 SOTA 성능을 달성했습니다. 비디오를 통해 3D 장면을 해석하고 이해할 수 있어, 기존 모델보다 더욱 효율적인 연구입니다.

하지만 RGB가 아닌 Depth를 포함하는 비디오기 때문에 이는 확장 가능성이 있어보입니다.